La photographie en temps réel à l'aide de caméras Raspberry Pi ?

Nous avons commencé à travailler sur une version PiCam de notre logiciel multi-caméras il y a quelques mois, mais cela n'avait rien à voir avec notre travail habituel sur le bullet-time. Il s'agissait principalement de photogrammétrie, qui devrait ressembler à notre système DSLR, avec des caméras beaucoup plus petites. Et cette partie est prête.

Mais comme nous disposions de l'équipement et du logiciel, j'ai voulu voir jusqu'où nous pouvions aller avec le bullet-time et quel type de qualité d'image je pouvais obtenir avec ces minuscules caméras. Ce qui m'intéresse surtout ici, c'est leur taille, car elles peuvent être placées très près les unes des autres, ce qui me permet d'obtenir la meilleure densité jamais obtenue sur une structure à plusieurs caméras.

Comme pour l'édition Android ou DSLR, un tableau de bord permet de modifier les paramètres de la caméra et les paramètres de sortie. Nous avons également notre lecteur de lecture instantanée habituel, notre galerie et des tonnes de modules.

Sur la première itération du kit, je n'ai pas pu obtenir une bonne calibration car les lentilles de la PiCam sont montées sur une pâte thermique et ne peuvent pas être placées avec précision. Voici ce que j'ai obtenu avec ce premier kit. C'est assez instable. Le problème est qu'il s'agit d'objectifs très larges, et avec la distorsion, j'ai vraiment besoin que toutes les caméras regardent le même point central. Mais comme j'étais de plus en plus intéressé par les résultats finaux que j'obtenais, nous avons essayé de voir si nous pouvions nous débarrasser de cette pâte pour coller les objectifs directement sur les petites planches. Ce n'est pas parfait, mais on s'en rapproche. Voici mon kit actuel!

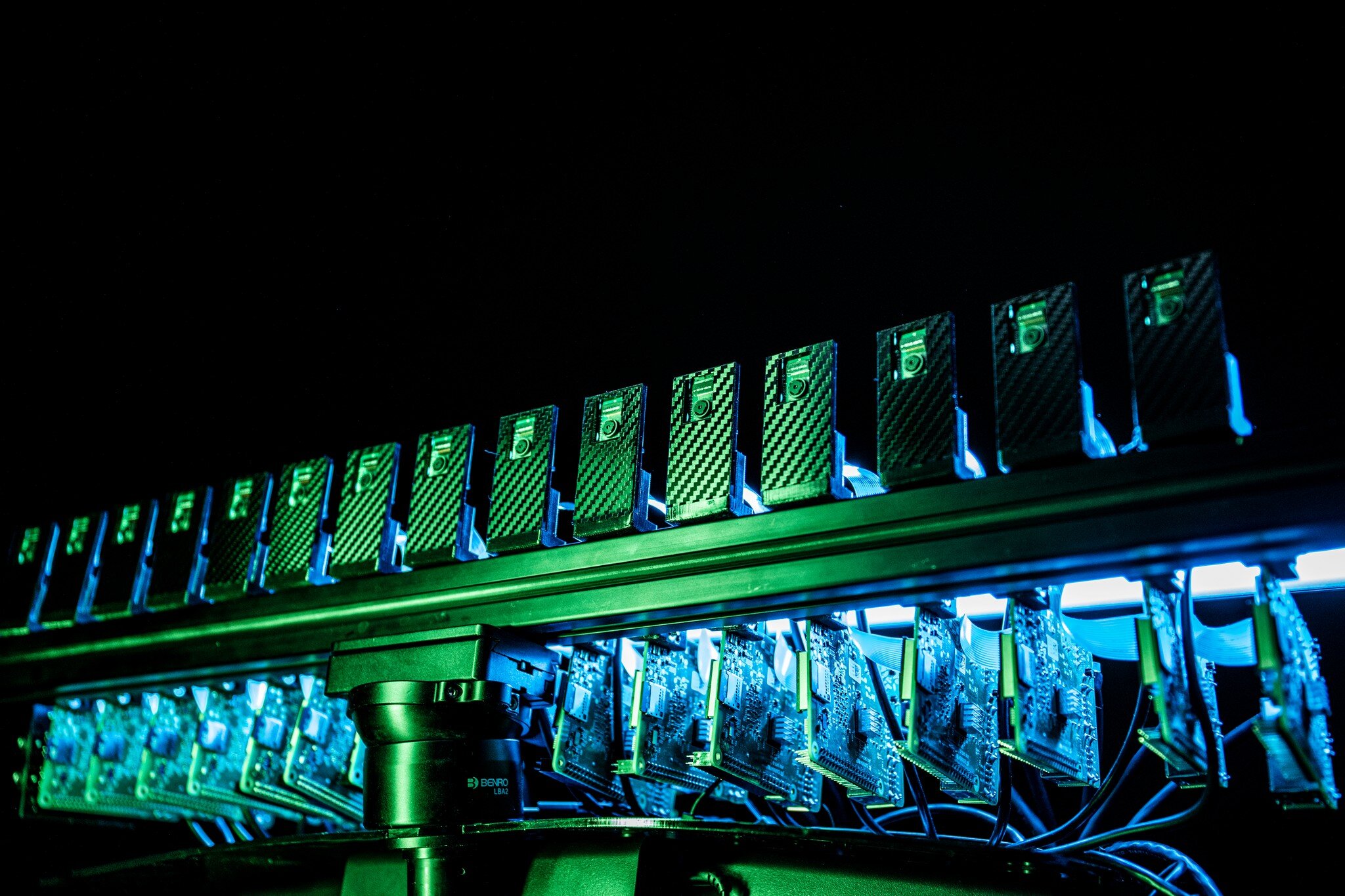

Pour tous mes tests en lumière continue, j'utilise 15 PiCam sur 15 Raspberry Pis 3b+ sans aucun composant électronique personnalisé. Chaque Pi envoie ses données via des câbles Ethernet aux commutateurs et à l'ordinateur portable. Mon déclencheur est un simple présentateur powerpoint bluetooth. Mais pour mes prises de vue utilisant un stroboscope externe, nous avons dû concevoir un petit circuit imprimé pour envoyer le signal à mon speedlite. La carte se trouve sur le dernier pi, et est reliée au flash par un câble audio et un adaptateur hot shoe. N'importe quel type de flash peut faire l'affaire.

Les cartes Picams sont montées sur des plaques acryliques découpées au laser qui se connectent à une barre en aluminium extrudé via ces adaptateurs imprimés en 3D. Chaque

J'ai réalisé ce projet dans le cadre d'une expérience intéressante, et il ne remplacera jamais mes reflex numériques, mais il ouvre la voie à différentes manières d'utiliser cette technologie.

*** MISE À JOUR 4 octobre 2020

Ce projet a été publié sur hackaday.com et certains commentaires sont très intéressants à lire. Je ne m'attendais pas à ce que ce genre de personnes interviennent et je suis très heureux d'entamer cette discussion avec des gens qui ne font pas partie de mon cercle habituel. Voici une réponse détaillée à ce commentaire

dit Scott:

Je ne pense pas que les Pi soient en train de recoder de la vidéo - ils prennent chacun une photo lorsque Eric appuie sur le clicker Bluetooth qu'il tient dans sa main. Les photos sont assemblées pour créer la vue "bullet time". Il semble que le logiciel personnalisé qui contrôle tous les Pi envoie un paquet de diffusion lorsque Eric déclenche le clicker. Si vous regardez attentivement la vidéo, la LED d'activité Ethernet clignote une fois sur chaque Pi au même moment où la photo est prise. Une solution plutôt ingénieuse :-)

Scott, vous avez raison, nous prenons une photo de chaque PiCam en même temps. Lors de notre première itération, nous prenions une image d'une vidéo, mais cette technique ne fonctionne pas très bien avec la PiCam HQ car nous ne pouvons pas gérer les 13mp en continu sur la vidéo. Passer à des images "fixes" était la solution pour avoir un système qui fonctionne à la fois sur la PiCam v2 et la Pi Camera HQ.

Maintenant, qu'en est-il de la précision du déclenchement ? Nous savons que nous pouvons envoyer un signal synchronisé avec une précision de moins d'une milliseconde à tous les Raspberry Pis, et cet exemple montre bien à quel point cela peut être génial lorsque l'on travaille avec l'équipement adéquat. Cette photo a été réalisée en utilisant 154 Canon SL1 avec une lumière constante et 4 caméras par Pi (39 Raspberry Pi). Mais c'est quelque chose qui ne peut être réalisé qu'avec des caméras DSLR ou quelques récentes caméras sans miroir (cela fonctionne bien avec l'EOS-R mais pas avec le M6 MkII). Pour tout le reste (Raspberry Pi, smartphones Android, GoPro, etc.), nous sommes confrontés à des problèmes d'obturation lorsque le taux de rafraîchissement n'est pas synchronisé (gen locked) sur toutes les caméras. Cela signifie généralement une imprécision d'environ 1/60s, ce qui est loin d'être suffisant pour figer un sujet (nous avons besoin d'une précision de 1ms !).

Alors, comment ai-je réussi à me figer sur ces photos ? J'utilise simplement le vieux truc qui consiste à déclencher mon flash dans l'exposition à un moment "sûr". Par exemple, si ma vitesse d'obturation est de 1/2 seconde, je déclenche le flash 1/4 seconde après le signal de déclenchement initial, ce qui laisse suffisamment de temps pour que toutes les unités soient en train d'exposer lorsque la lumière s'allume. C'était assez facile à réaliser car j'avais cette carte qui rendait tout automatique. Mais l'année dernière, j'ai eu du mal à faire la même chose avec un téléphone Android où j'avais besoin de flasher manuellement pendant mon exposition d'une seconde (plus d'exemples sur la barre latérale droite de SlimRig.com).

Galerie d'images du projet